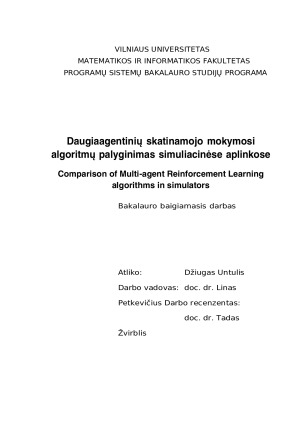

Daugiaagentinių skatinamojo mokymosi algoritmų palyginimas simuliacinėse aplinkose

Detali informacija

Ištrauka

Daugiaagentinių skatinamojo mokymosi algoritmų palyginimas simuliacinėse aplinkose

Bakalauro baigiamasis darbas

Turinys

ĮVADAS 6

1. DAUGIAAGENTINIS SKATINAMASIS MOKYMASIS 8

1.1. Įvadas j skatinamąjj mokymą 8

1.2. Markovo sprendimo priėmimo procesai 8

1.3. Pagrindinės skatinamojo mokymosi sąvokos 9

1.4. Skatinamojo mokymosi algoritmai 10

1.4.1 Ve

rtės funkcijos iteracija grindžiami algoritmai 10

1.4.2. Strategijos iteracija grindžiami algoritmai 10

1.4.3 Akt

oriaus-kritiko algoritmai 10

1.5. Daugiaagentinio mokymosi algoritmai 11

1.5.1. Įvadas j daugiaagentinj skatinamąjj mokymą 11

1.5.2. IPPO 11

1.5.3. MAPPO 12

1.5.4. QMIX 12

2. EKSPERIMENTINIO TYRIMO APLINKA 14

2.1 „M

elting Pot“ simuliacinė aplinka 14

2.2 „T

orchRL“ biblioteka 16

2.3 „W

eights & Biases“ platforma 16

2.4. Eksperimentų atlikimas 16

3. DAUGIAAGENTINIO MOKYMOSI ĮVERTINIMO RODIKLIAI 17

3.1. Bendro atlygio vidurkis 17

3.2. Lygybės rodiklis 17

3.3. Tvarumo rodiklis 17

4. EKSPERIMENTINIS APLINKOS „BENDRUOMENIŲ DERLIAUS NUĖMIMAS“

TY- RIMAS 18

4.1. Atsitiktinė strategija 18

4.2. IPPO 18

4.2.1. Bendra eksperimentų konfigūracija 18

4.2.2. Pirmas eksperimentas - individualus atlygis, dalinamasi

parametrais 19

4.2.3 An

tras eksperimentas - bendras atlygis, dalinamasi

parametrais 20

4.2.4 Tr

ečias eksperimentas - bendras atlygis, nesidalinama

parametrais 21

4.2.5. Ketvirtas eksperimentas - individualus modifikuotas atlygis

22

4.3. MAPPO 23

4.3.1. Pirmas eksperimentas - individualus atlygis 23

4.3.2 An

tras eksperimentas - individualus modifikuotas atlygis 24

4.4. QMIX 25

4.4.1. Pirmas eksperimentas - individualus atlygis 26

4.4.2 An

tras eksperimentas - individualus modifikuotas atlygis 27

5. EKSPERIMENTINIS APLINKOS „UPĖS VALYMAS“ TYRIMAS 28

REZULTATAI 30

IŠVADOS 32

PADĖKA 33

ŠALTINIAI 34

PRIEDAI 37

Įvadas

Daugiaagentinis skatinamasis mokymasis (angl. Multi-agent

reinforcement learning, dažnai trumpinama kaip MARL) - sritis, nagrinėjanti

algoritmus ir strategijas, leidžiančias keliems agen- tams mokytis

bendradarbiauti, prisitaikyti ir priimti sprendimus bendroje aplinkoje.

Pastarai- siais metais MARL sulaukė nemažai dėmesio dėl gebėjimo

spręsti sudėtingas realaus pasaulio problemas, su kuriomis tradicinis

skatinamasis mokymasis nepajėgus susidoroti. Keletas pavyz- džių -

MARL pritaikymas siekiant pagerinti kompiuterinių tinklų paketų

maršrutų paskirstymą [YLX+22], tiriant saugių autonominių vairavimo

sistemų kūrimą [SSS16] ar sprendžiant optima- lios mokesčių politikos

formavimo problemą, kuria siekiama pagerinti socialinę gerovę

[ZTS+22]. Dėl augančio pritaikomumo, didėja ir daugiaagentinių

skatinamojo mokymosi algoritmų tyrimų poreikis.

Skirtingai nuo tradicinio skatinamojo mokymosi, kurio metu agento

tikslas yra efektyviai maksimizuoti tikėtiną grąžą, daugiaagentinio

skatinamojo mokymosi atveju - kartais tikslai nėra taip aiškiai apibrėžti.

Egzistuoja dvi pagrindinės tyrimų kryptys [DLI+23]: viena jų orientuota

j bendrų verčių maksimizavimą [RSW+18], apibūdinama kaip

komandiniai Markovo žaidimai arba keleto agentų Markovo sprendimo

priėmimo procesai (angl. Markov Decision Process, dažnai trumpinama kaip

MDP), o kita siekia rasti bendrą pagrindą tarp agentų ir skatinti jų

socialinę gerovę arba išvengti socialinių dilemų [MRK+23].

Abi šios sritys susiduria su bendra problema - daugiaagentinės

sistemos ne stocianarumu. Daugiaagentinės sistemos pasižymi ne

stacionarumu, [DLI+23], kadangi bet kurio agento stra - tegijos

patobulinimą kiti sistemos agentai patiria kaip jų patirties

pasiskirstymo pokytj. Be to, didėjant agentų skaičiui eksponentiškai

didėja ir bendra atliekamų veiksmų erdvė. Dėl to algo- ritmų, kuriais

bandoma tiesiogiai modeliuoti bendrų veiksmų erdvę, mokymo laikas

gali išaugti. Pažymėtina ir tai, kad tyrinėjimas, esantis vienu iš

pagrindinių skatinamojo mokymosi dalių, tampa sudėtingesnis, nes

būtina koordinuoti tyrinėjamų veiksmų pasirinkimą.

Kita pastebima problema - sudėtingesnis agentų

bendradarbiavimas esant paskatai konku - ruoti [DLI+23]. Pavyzdžiui,

futbolo žaidime, nors žaidėjai siekia komandos pergalės, premijos už

jmuštus jvarčius gali sukelti konfliktų. Jei svarbi būtų tik komandos

sėkmė, žaidėjai laikytų- si optimalios komandos strategijos, pvz.,

perduotų kamuolj, kad padidintų šansus jmušti jvartj.

Mūsų mokslo darbų bazėje yra daugybė įvairių mokslo darbų, todėl tikrai atrasi sau tinkamą!